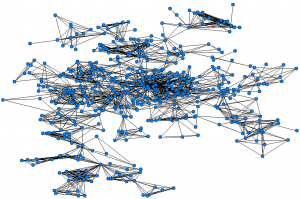

Abbiamo visto nel precedente articolo che reti diverse hanno non solo numeri molto diversi di nodi, ma anche nodi molto diversi tra loro, come nel caso dei profili Twitter che possono avere decine di milioni di nodi o nessuno. I ricercatori che studiano le reti però non si accontentano di descrivere l’eterogeneità del grado dei nodi di una rete: cercano anche di spiegarla.

Molto a pochi

Ovviamente non ci sarebbe ragione di aspettarci che tutti i profili Twitter abbiano lo stesso numero di follower, così come se convochiamo in una stanza un certo numero di persone non abbiamo motivo di aspettarci che siano tutte ugualmente alte. Quello che vorremmo spiegare è però come mai esistano (molti) profili milioni di volte più seguiti di (moltissimi) altri. Non può essere solo un caso: o, meglio, può esserci ovviamente di mezzo il caso, ma vogliamo capire come il caso possa portare a differenze così estreme.

Perché?

Una risposta semplice – troppo – sarebbe che le persone scelgono liberamente quali account Twitter seguire, mentre i genitori non scelgono l’altezza dei propri figli. Tuttavia, immaginiamo di studiare un migliaio di persone che entrano in un centro commerciale: se scoprissimo che tutti si concentrano in un paio di negozi, considerando poco o nulla gli altri, non ci accontenteremmo di concludere “l’hanno scelto”. Da scienziati sociali, vorremmo capire perché tendano a fare tutti le stesse scelte. E questo problema riguarda non solo Twitter, ma anche la rete delle pagine web e varie altre reti sociali.

Vantaggi cumulati

Una possibile spiegazione fu data nel 1976 da Derek de Solla Price, un fisico che, appassionatosi di quella che sarà in seguito chiamata scientometria, cioè lo studio di quanto e come gli scienziati pubblicano le loro ricerche, si dedicò in particolare alla comprensione della rete delle citazioni tra articoli scientifici. Cercando di spiegare come mai alcuni articoli scientifici attraessero molte più citazioni di altri – cioè avessero un grado in entrata maggiore – Price suggerì il meccanismo del vantaggi cumulati. In pratica, ogni volta che un articolo è citato da un altro, questo fa sì che altri ricercatori (quelli che leggono l’altro articolo) vengono a conoscenza della pubblicazione originaria, magari leggendola e poi citandola. Quindi più un articolo ha archi in entrata – citazioni – più tenderà ad accumularne.

Effetto Matteo

Già un altro ricercatore, Robert K. Merton, aveva ipotizzato nel 1968 che nelle scienze fosse all’opera un “Matthew effect” (dal passaggio del Vangelo di Matteo “A chiunque ha sarà dato e sarà nell’abbondanza; ma a chi non ha sarà tolto anche quello che ha”) per cui, in sintesi, i ricercatori già più famosi hanno più facilità a diffondere ulteriormente le loro idee e quindi affermarsi ulteriormente, rispetto a quelli più sconosciuti. De Solla Price ebbe il merito di trasformare questa intuizione in una regola matematica rigorosa che spiegasse la specifica distribuzione di citazioni osservata nella rete degli articoli scientifici. La stessa regola fu poi adottata nel 1999 dai fisici Albert-László Barabási e Réka Albert, con il nome di preferential attachment (letteralmente “attaccamento preferenziale”) per descrivere la crescita di un’altra rete: il web. Anche in questo caso, il meccanismo dei vantaggi cumulati è perfettamente sensato: se a una pagina web puntano collegamenti da tante altre pagine, è più facile che chi naviga il web finisca per leggerla… e quindi magari, nello scrivere nuove pagine web, per farci puntare altri collegamenti.

Arriva Google

Il fatto che gli archi nelle reti sociali (amicizia su Facebook, citazioni tra articoli, link tra pagine web) non si costruiscano a caso, ma siano il risultato di scelte, non è importante solo per spiegare il grado dei nodi, e più in generale la struttura delle reti. Permette anche di estrarre informazione da una determinata rete. Un utilizzo intelligente dell’informazione contenuta nelle reti è ad esempio quello che ha permesso a Google, alla fine degli anni Novanta, di sbaragliare rapidamente la competizione degli altri motori di ricerca.

Il garage dove è nato Google, a Mountain View, California.

Ricerca intelligente

Per capire l’importanza della novità che Google ha rappresentato dobbiamo pensare che quando un utente cerca su un motore di ricerca la parola “gatto”, il motore di ricerca deve fare due cose: primo, scandagliare il proprio archivio di pagine web in cerca di tutte quelle che contengono la parola. E questa è la parte facile, o perlomeno che all’epoca era già sostanzialmente risolta. Il difficile veniva dopo: mettere le pagine in un ordine sensato, per esempio facendo in modo che in prima pagina ci fossero quelle più interessanti per un utente. A fine anni Novanta, per questo secondo passaggio venivano utilizzati diversi approcci, come considerare migliori le pagine in cui la parola in questione appariva più volte, o in posizione più rilevante, o consultare delle specie di cataloghi creati dagli utenti. Ma tutti questi approcci erano insoddisfacenti – i cataloghi richiedevano un grande lavoro manuale e ogni ragionamento sul contenuto era facilmente manipolabile dagli autori delle pagine. Google, o meglio i suoi due fondatori Brin e Page, ebbero l’idea di sfruttare la rete delle citazioni tra le pagine per capire quali fossero più rilevanti. Intuitivamente, osservarono che una pagina con più archi (link) in entrata sarebbe stata presumibilmente più interessante (dato che era risultata interessante a chi aveva fatto quei link). Ma non si fermarono qui: pensarono che avrebbero dovuto considerarla tanto più interessante quanto più le pagine da cui provenivano quei link fossero state interessanti. Può sembrare un cane che si morde la coda far dipendere l’importanza di una pagina dall’importanza delle pagine che hanno link verso quella pagina – e infatti è quel che si dice una definizione ricorsiva – ma funziona, e l’algoritmo risultante, il cosiddetto PageRank, è anche relativamente robusto alla manipolazione (non è facile per l’autore di una pagina “truccarne” l’importanza).

Banche e scienza

Il PageRank non è più il solo criterio che Google utilizza per ordinare i suoi risultati; in cambio, nel frattempo algoritmi ispirati dal PageRank si sono rivelati utili per analizzare anche reti di tutt’altra natura. Per esempio, Eigenfactor viene utilizzato per valutare l’importanza delle riviste scientifiche – con le citazioni tra articoli scientifici che prendono il posto dei link tra pagine web – e DebtRank per misurare l’importanza sistemica di una banca o di un altro istituto finanziario, in base alla rete del credito. Vale la pena di menzionare che mentre link tra pagine web e citazioni tra articoli scientifici si possono considerare tutti uguali, di certo non sono tutte uguali le relazioni di credito tra banche – possono riguardare somme maggiori o minori di denaro. Ma gli algoritmi tipo PageRank si prestano facilmente ad essere applicati anche a reti pesate, come appunto la rete del credito… o quella dei risultati sportivi.

Link e approfondimenti

• Il libro La responsabilità di rete (il Mulino) di Pietro Battiston, e il suo sito.